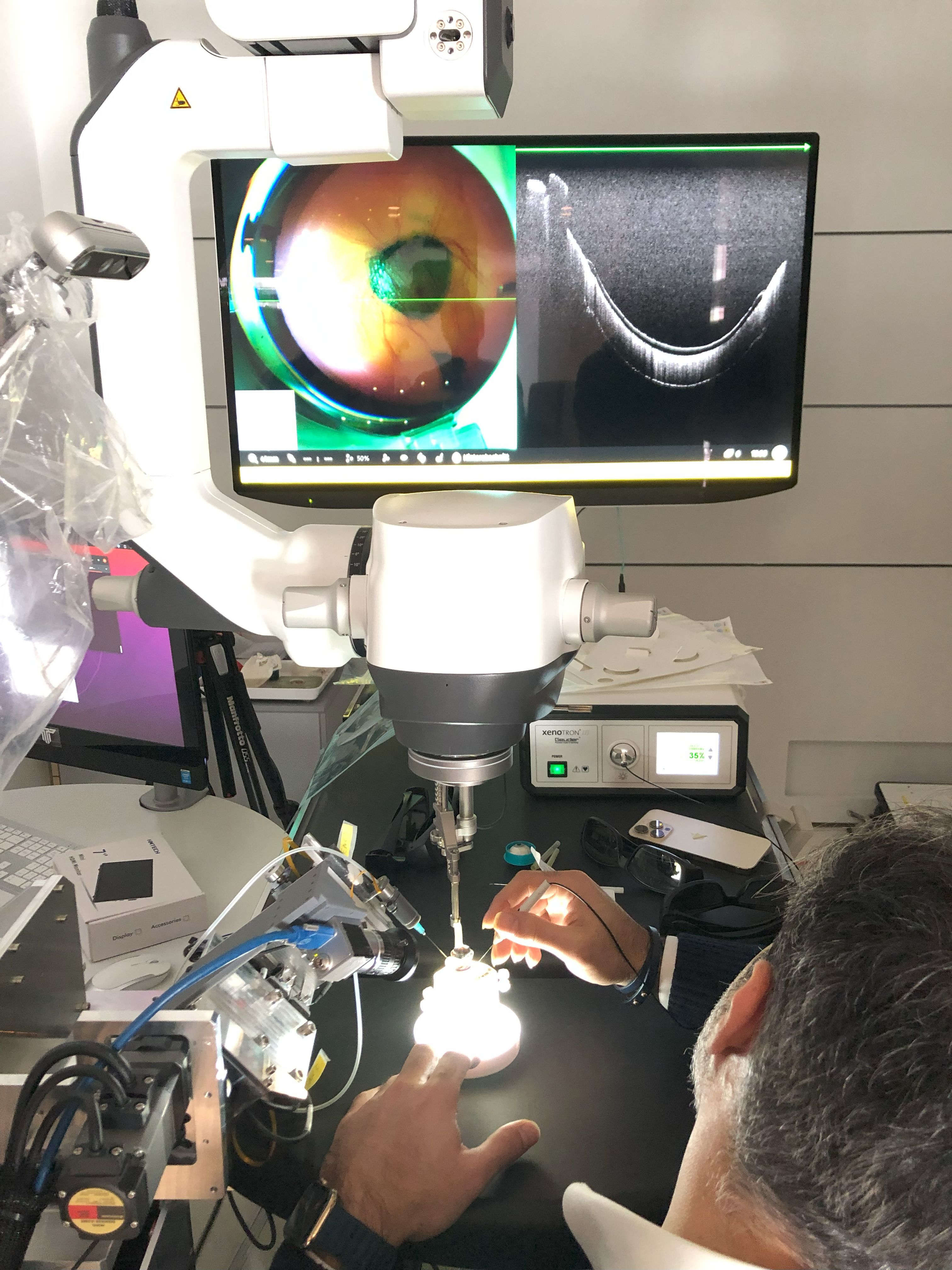

Mit 3D-Laserscannern lassen sich heute 3D-Modelle unserer Umgebung mit hoher Genauigkeit erstellen. Obwohl die räumliche Auflösung im Bereich weniger Millimeter liegt, reicht sie noch nicht an die von Kameras gewohnte Auflösung heran. Eine direkte Darstellung der gemessenen Laser-Punkte hat daher bei weitem nicht die Qualität eines Fotos. Panoramabilder, also 360°-Aufnahmen, werden deshalb gerne eingesetzt, um eine Sicht auf die aufgenommene Szene in der Qualität eines Fotos zu ermöglichen.

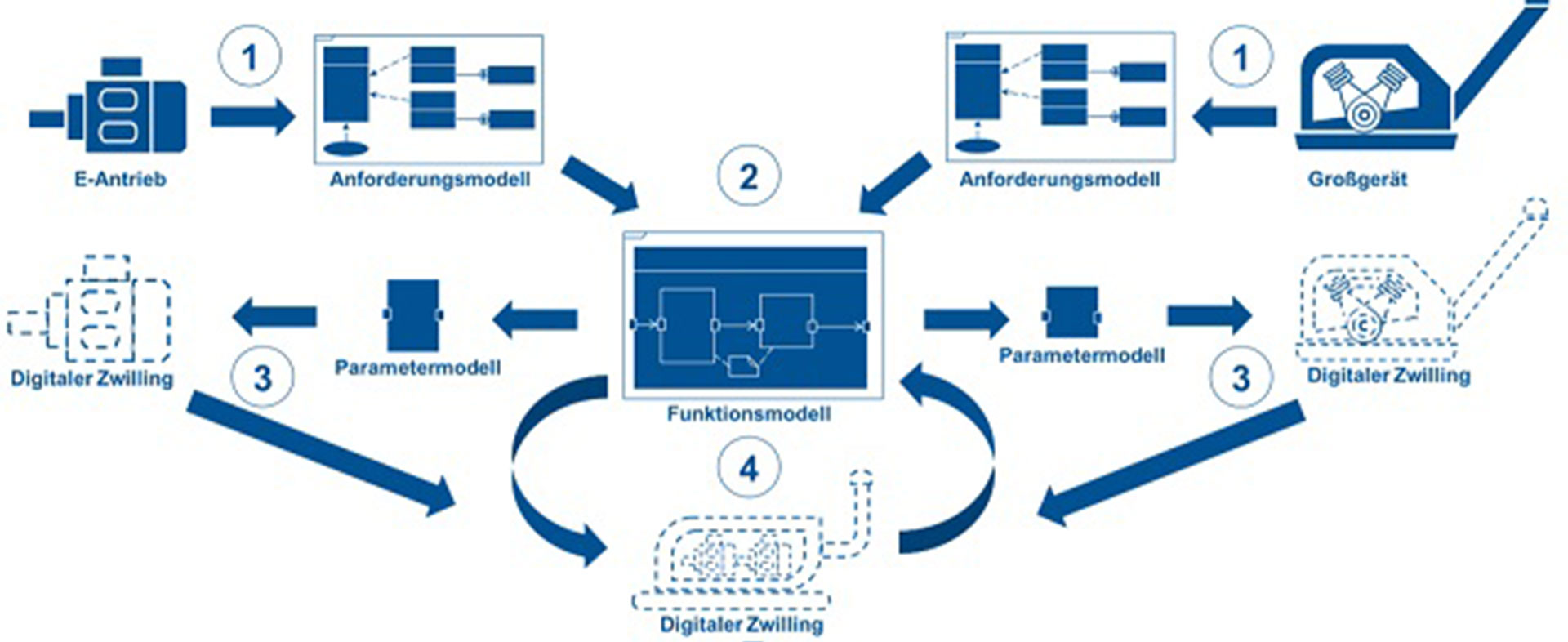

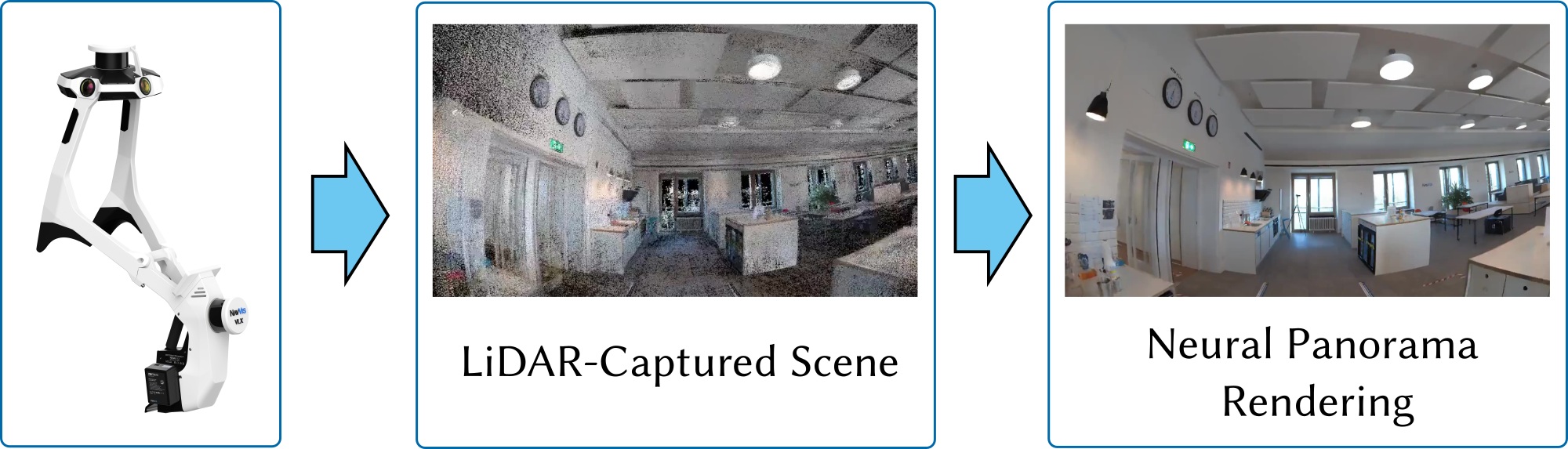

Ziel des Projektes war es, neue Verfahren zu entwickeln, die mittels maschinellen Lernens beide Welten verbinden. Es sollte somit möglich werden, aus einer 3D-Punktewolke und einer Reihe von 360°-Aufnahmen beliebige neue Panoramen oder neue Zwischenansichten in der Qualität eines Fotos zu erzeugen.

Dazuwurde im Rahmen des Projekts ein neues Verfahren zur Erzeugung neuer Ansichten aus einem Laserscan und Fotoaufnahmen entwickelt. Dabei werden die 3D-Laserpunkte dazu verwendet, eine erste grobe, „löchrige“ Ansicht zu erstellen. Diese Ansichten werden dann mittels tiefer neuronaler Netze, die auf den Fotografien trainiert wurden, in fotorealistische Bilder transformiert. Diese Grundidee wurde im Laufe des Projektes kontinuierlich weiterentwickelt, bis am Ende die Erzeugung neuer fotorealistischer Ansichten in wenigen Millisekunden möglich wurde.

Mit dem Ende des Projektes ist nun ein System verfügbar, mit dem Benutzer frei in einer mit einem Laserscanner und Fotokameras aufgenommenen Szene wie in einem Computerspiel spazieren gehen und sich in Foto-Qualität umsehen können. Das System kann auch mit einer VR-Brille genutzt werden, um den Benutzer virtuell in die Szene eintauchen zu lassen.